ビッグデータのことをあなたはこんなふうに思っていないでしょうか。

「あんな手品のような分析は世界的企業や最先端の技術者だからできることで、自分のビジネスとは、別世界の出来事じゃないか」

一面的には、その感覚は正しいといえます。

それは、世界的企業にはデータの塊を宝の山に変えるだけの環境があるからです。

企業経営と同じで、ビッグデータの利用にも「ヒト」「モノ」「カネ」の要素は不可欠です。

しかし、別世界のものと線引きする必要はありません。

ビッグデータの「ビッグ」さにもいろいろありますし、その分析手法も、「ヒト」「モノ」「カネ」が十分でなくとも実現するものが数多くあります。

むしろ、最先端企業が取り扱う巨大データではなく、もっと身近なところで手つかずのまま放置されている「ビッグデータ」こそが、ビジネスを変革する可能性の高いジャンルでもあるのです。

まずビッグデータとは何かということから整理していきましょう。

総務省の情報通信白書では、毎年のようにビッグデータの定義と現状について解説がなされていますので、その一部を紐解いてみます。

ビッグデータの定義及び範囲

デジタル化の更なる進展やネットワークの高度化、またスマートフォンやセンサー等IoT関連機器の小型化・低コスト化によるIoTの進展により、スマートフォン等を通じた位置情報や行動履歴、インターネットやテレビでの視聴・消費行動等に関する情報、また小型化したセンサー等から得られる膨大なデータ、すなわちビッグデータを効率的に収集・共有できる環境が実現されつつある。特に、近年ビッグデータが注目されているのは、従来のICT分野におけるバーチャル(サイバー空間)なデータから、IoTの進展などを始め、新たなICTにおけるリアルなデータへと、あるいはB to CのみならずB to Bに係るデータへと爆発的に流通するデータ種別へと拡大しているためである。

世界のトラヒックの状況についてみると、米Ciscoによれば2015年から2020年にかけて年平均成長率22%(5年間で約2.7倍)でさらに増加していくことが予想されている。2020年には1か月あたり194エクサバイト(EB)、年間にすると2.3ゼタバイト(ZB)に達する。特に、モバイルデータは年平均成長率53%(5年間で約7.8倍)で増加し、全体の伸びを牽引していくことが予想される。(平成29年版)

と、世界中で急速に増えているデータの存在が紹介され、それがネットワーク化、あらゆるところに組み込まれた各種のセンサーから自動的に集められるデータであると分析されています。

そしてそれらのデータを以下の4つのカテゴリーに分類しています。

ビッグデータという言葉でくくれないほど、種類も用途もバリエーションが多彩であり、それぞれのジャンルの中で新たな可能性を秘めているというのが、その大意です。

これらのデータはどんな特徴を持っているのでしょうか。

一般的には3つの「V」という言葉で説明されることが多いので、ここではそれを紹介します。

注目しておくべきは、ビッグデータに関してのデータ量について明確な基準はないことです。

あえて定義するとしたら一般的な手段では処理しきれない量があり、構造的には自動生成されたり、新たにデータ化された知見、広く一般に公開されるようになっているデータが新たな社会的資産になるほど膨大な量、とでもなるでしょうか。

それが1の流通量の意味です。

センサーや機器からもデータは自動的に瞬時に生成され、それがインターネットなどを通じて集められています。

従来の各種の統計調査や定期的に集められるデータとは違い、生成・収集にいたるまでの速度が格段に早いというのが2番目の速度の特徴です。

問題になるのは、3番目に取り上げられている種別です。

非構造化という言葉が使われますが、これは表計算やデータベースで使われるような整った形のものだけでなく、画像、動画、PDF、音声、テキスト、ワープロ文書、センサーが生み出す数値など、ありとあらゆる形式のデータが山のように集まってビッグデータを構成しているという意味です。

こうした特徴を持ったビッグデータから、社会問題の解決やビジネスの成功に役立つ知見を得ることができると期待されているので、情報通信白書も毎年のようにビッグデータに関する特集を取り上げているのです。

これに付随するように、このビッグデータを効率的に分析するツールとして取り上げられるのが人工知能(AI)であり、機械学習、ディープラーニングというキーワードであると理解すれば、大まかな流れをつかむことができるでしょう。

ビッグデータの量的な定義はあいまいだと書きましたが、漠然と共通認識となっているデータ量の目安がないわけではありません。

それは、ローカルのパソコンや一般的なデータベースソフトでは処理しきれず、ネットワークでつないだコンピュータを使って、最新のデータベースを使うのに適したデータ量というものです。

実際にHadoopやNoSQLという仕組みに注目が集まるのは、大量のデータ処理という課題による要因が大きいと思われます。

しかし、課題解決に役立つビッグデータは、果たしてそれだけビッグなものばかりなのでしょうか。

あらゆる企業や団体には、日々蓄積されるデータがあります。

もちろん、あなたの身の回りにも存在します。

それは経理や販売の数値データだけではなく、社員が書く日報、統計、調査レポート、メール、取引先から提供される報告書など、コンピュータやセンサーがあるところで、データは常に生成され続けています。

それもまた、3つのVの条件を少しずついたしたビッグデータです。

ではなぜ、身の回りにあるビッグデータは奇跡を起こしてくれないのでしょうか。

事業を進める上でのデータ処理における課題について、いくつかのポイントを自らのビジネスに照らしてみてください。

4つのどれか、もしくはすべてに何らかの障害があると感じていないでしょうか。

こうした問題を解決するのが、データを高度に分析する専門家であるデータサイエンティストやデータアナリストと呼ばれる人間ですが、その人数は、とても少ない状況にあります。

数の問題だけではなく、そうした専門家を社内で抱えられる、言い換えれば、データの処理分析に専門家を雇うだけの経済的なメリットを理解できている企業もまた少ないはずです。

事業部やプロジェクト単位のビジネスで利用するデータの量はそれほど大きくなく、データ分析によって業務改善、市場開拓の期待値が人件費をあきらかに上回るほどでない場合はなおさらです。

しかし、ビジネスの現場におけるデータ分析のニーズとは、むしろそのレベルのもののほうが多いのです。

現実のリアルなデータ分析とは、目の前にあるデータを、統計や表計算ソフトに多少心得のある担当者が試行錯誤しながら分析を試みる。

それで解決策が見つかればいいのですが、できない場合はデータが宝の山とわかっていても放置され、旧来の経験と勘の判断に委ねられます。

たとえうまくいった場合でも、担当者が変わったら新しい分析に対応できなくなります。

そんな状況は、誰もが日常的に目にしているはずです。こういう現場からのSOSを受けて、私たち専門家の仕事が生まれてくるのです。

それでは、ビッグデータ分析における問題点とはなんでしょうか。

量の大小を問わず、データから知見を得てビジネスにいかそうとするときには、いくつかの段階をふまねばなりません。

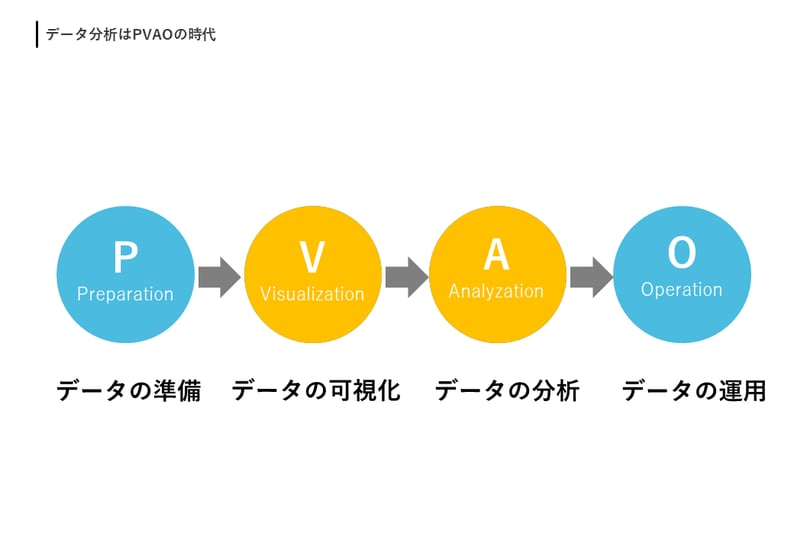

INSIGHT LABでは、各段階の頭文字をとってPVAOサイクルと名付けています。

データを収益につなげるには、このPVAOサイクルが滞りなく回転する必要があります。

それがビジネスの現場におけるデータ分析の基本的な流れです。

ここで1点、確認しておかねばならないことがあります。

多くのアナリティクスの解説書では「PAVO」として、可視化の「V」と分析の「A」の順番が逆になっていることです。

なぜ逆になっているのか。

これにはBIツールの利用が前提になっているかどうかで変わってきます。

BIツールを使わない場合は、意思決定をする人と分析する人は別人です。

分析には専門家の技術や熟練が必要になるからです。

意思決定者は企業経営者、分析者はデータサイエンティストのような分析の専門家や現場の事業担当者です。

分析者がデータの中から何がしかの知見を得て、それを意思決定者にわかりやすく伝えるために可視化をするという手順です。

つまり、「PAVO」の順番です。

しかし、BIツールの登場は、そのデータ分析基盤を使った意思決定者自身による分析を可能にしました。

BIツールを使えば、データを可視化して、コンピュータを高度に使いこなせなくても、可視化によって現状を正確に理解できるようになり、課題発見、問題解決のための分析をすることができるのです。

そのような理由から、INSIGHT LABのデータ分析の手順の定義としては、可視化が先で、分析が後の「PVAO」としています。

PVAOの詳細については以下のページで紹介していますので、ぜひ、参照下さい。